数据建模分析全流程指南:从入门到精通 | 帆软九数云

在当今数据驱动的时代,数据建模分析成为了企业决策和业务增长的关键。无论是理解客户行为、预测市场趋势,还是优化运营效率,都离不开对数据的深入挖掘和有效利用。本文将带你从零开始,全面了解数据建模分析的全流程。

一、数据建模的核心概念

数据建模分析的核心在于构建能够反映现实业务场景的数据模型,并运用分析方法从数据中提取有价值的信息。数据模型是对现实世界数据特征的抽象,它描述了数据的结构、关系和约束。通过对数据模型进行分析,可以更好地理解业务运作规律,发现潜在问题和机会。

二、数据建模的目的与类型

在进行数据建模分析之前,明确建模的目的至关重要。不同的业务需求需要构建不同的数据模型。常见的数据模型类型包括:

- 概念数据模型:侧重于业务视角的宏观描述,定义系统包含的数据和业务规则。

- 逻辑数据模型:进一步细化数据属性、主外键等,实现更具体的数据结构设计。

- 物理数据模型:对应数据库实际表结构,指导数据库建设,是逻辑数据模型在数据库中的具体实现。

选择合适的数据模型类型,可以有效地支撑后续的数据分析工作。

三、数据分析方法的选择与应用

选择了合适的数据模型后,需要根据业务目标选择合适的数据分析方法。常见的数据分析方法包括:

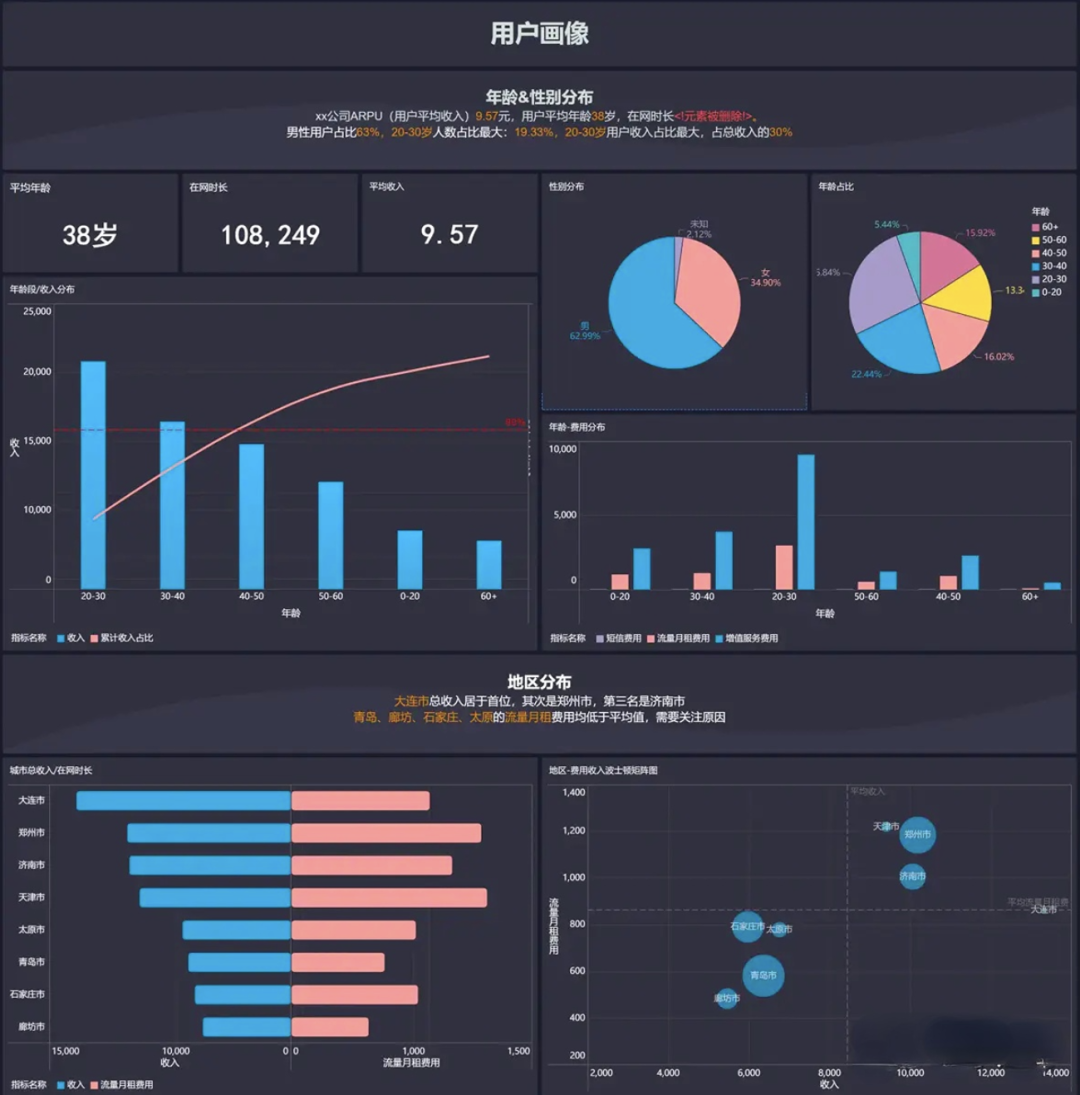

- 描述性分析:通过统计指标和数据可视化,总结数据的基本特征和分布规律,例如平均值、中位数、标准差等。

- 诊断性分析:深入挖掘数据,找出导致特定现象的原因,例如通过下钻分析找到销售额下降的原因。

- 预测性分析:利用历史数据建立模型,预测未来的趋势和结果,例如预测未来一段时间的销售额。

- 规范性分析:在预测性分析的基础上,给出最优的行动方案建议,例如在库存管理中,根据预测的需求量给出最优的补货策略。

根据不同的业务场景,灵活运用这些数据分析方法,可以获得更深入的洞察。

四、掌握数据预处理的关键步骤

数据质量直接影响数据建模分析的结果。因此,数据预处理是至关重要的环节,包括:

- 数据清洗:去除重复数据、纠正错误数据、填充缺失值等,保证数据的准确性和一致性。

- 数据转换:将数据转换成适合分析的格式,例如将日期格式统一、将文本数据进行编码等。

- 数据集成:将来自不同数据源的数据整合在一起,形成一个完整的数据集。

只有经过有效的数据预处理,才能保证分析结果的可靠性。

五、数据建模过程中的规范化原则

在数据建模分析过程中,遵循规范化原则可以有效地减少数据冗余,提高数据一致性,并优化查询效率。常见的规范化原则包括:

- 第一范式 (1NF):确保每个属性都是原子性的,不可再分。

- 第二范式 (2NF):在满足 1NF 的基础上,消除非主属性对主属性的部分依赖。

- 第三范式 (3NF):在满足 2NF 的基础上,消除非主属性对主属性的传递依赖。

适当的规范化可以提高数据模型的质量,但也需要根据实际业务需求进行权衡,避免过度规范化导致模型过于复杂。

六、模型评估与优化迭代

数据建模分析并非一蹴而就的过程。模型建立后,需要进行评估,并根据评估结果进行优化和迭代。常用的模型评估指标包括:

- 准确率 (Accuracy):衡量模型预测正确的比例。

- 精确率 (Precision):衡量模型预测为正例的样本中,真正为正例的比例。

- 召回率 (Recall):衡量所有正例样本中,被模型正确预测的比例。

- F1 值 (F1-Score):综合考虑精确率和召回率的指标。

- AUC:ROC 曲线下的面积,衡量模型对正负样本的区分能力。

根据业务目标选择合适的评估指标,并不断调整模型参数,可以提高模型的预测能力和实用价值。

七、九数云BI:赋能高效数据建模分析

对于高成长型企业而言,高效的 数据建模分析工具至关重要。九数云BI作为一款SAAS BI工具,能够帮助企业轻松应对数据挑战,实现数据驱动的增长。

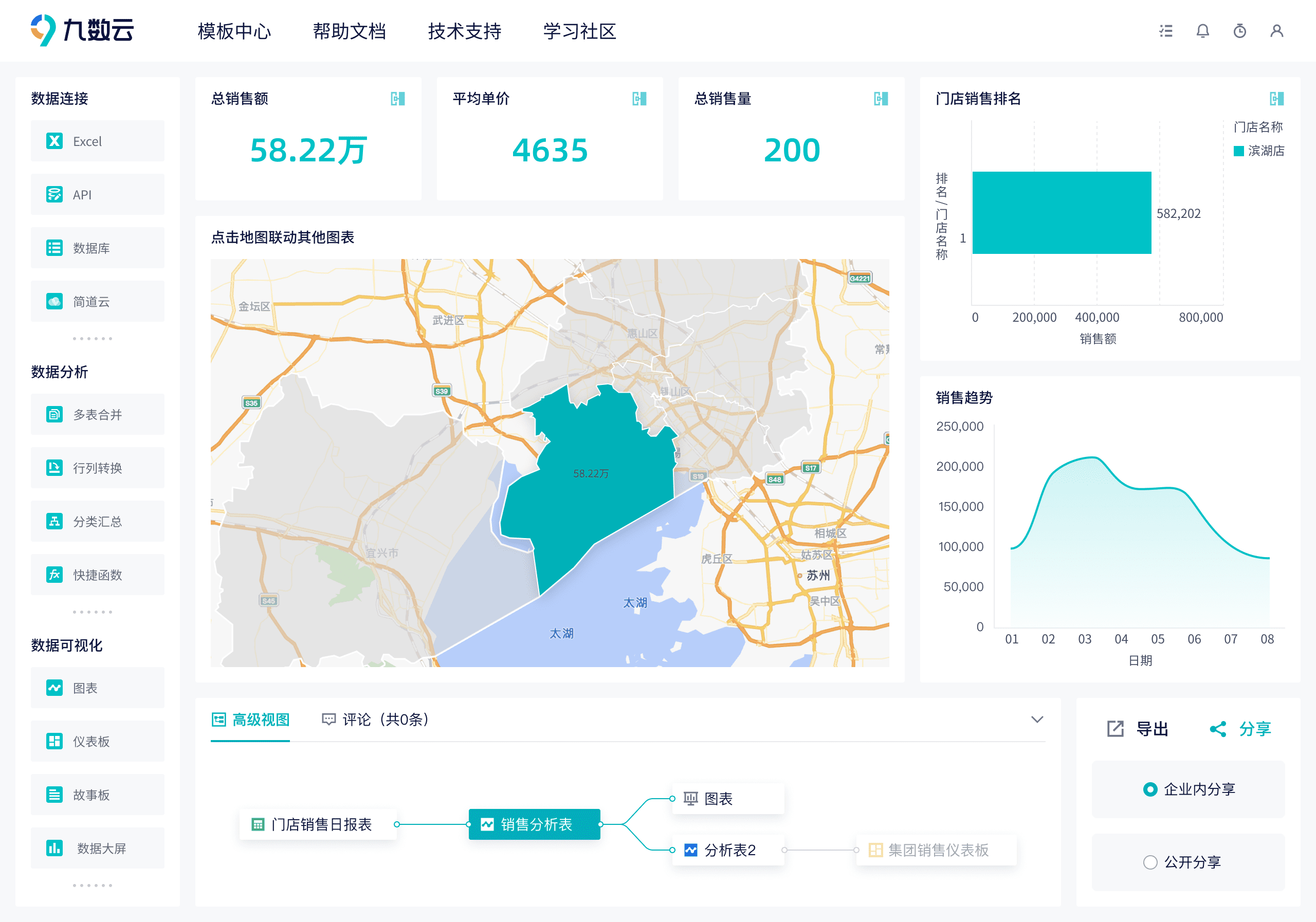

九数云BI支持API和RPA取数,能够轻松打通企业内部的各个数据源,包括电商平台数据、CRM数据、财务数据等。通过统一的数据集成,可以构建企业全景的数据视图,为后续的数据建模分析提供坚实的基础。

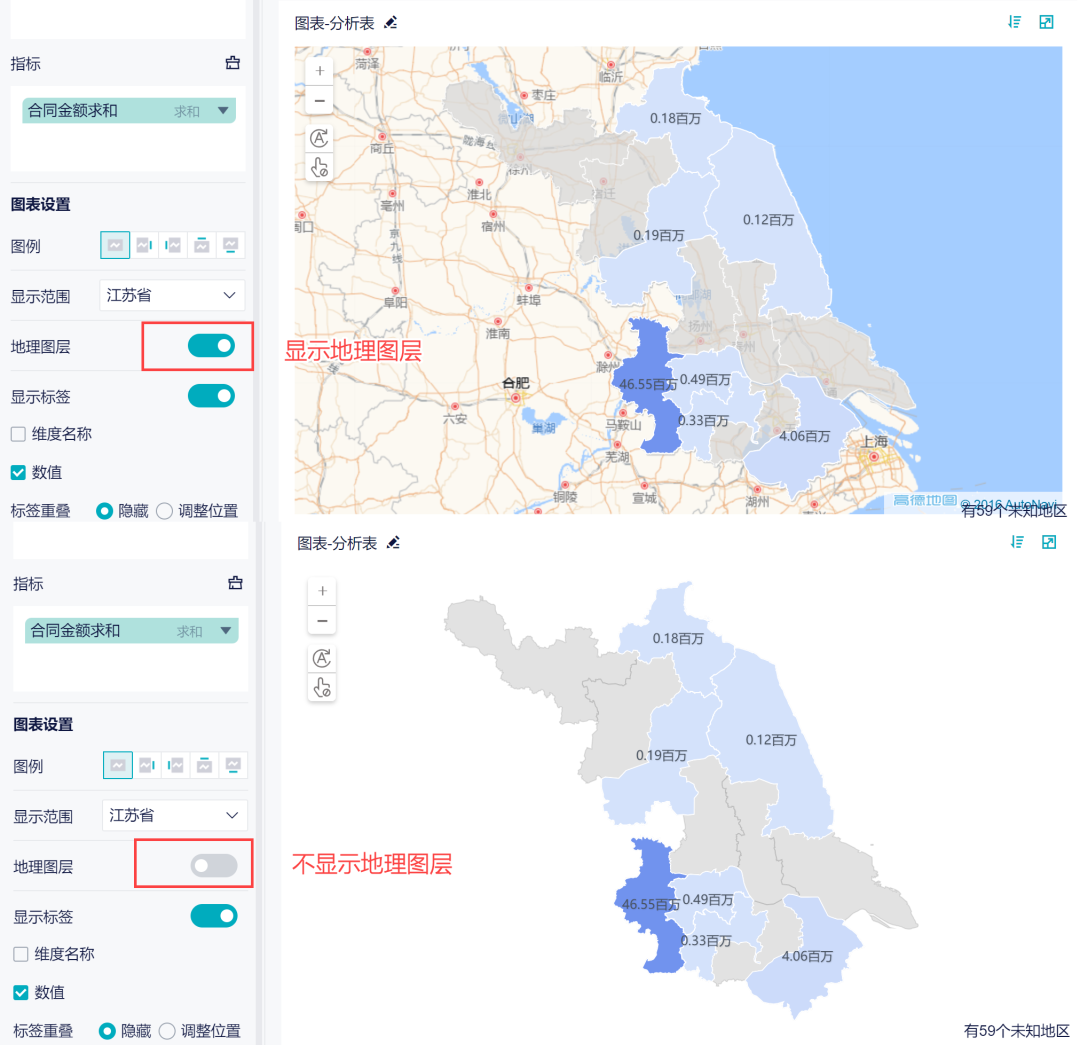

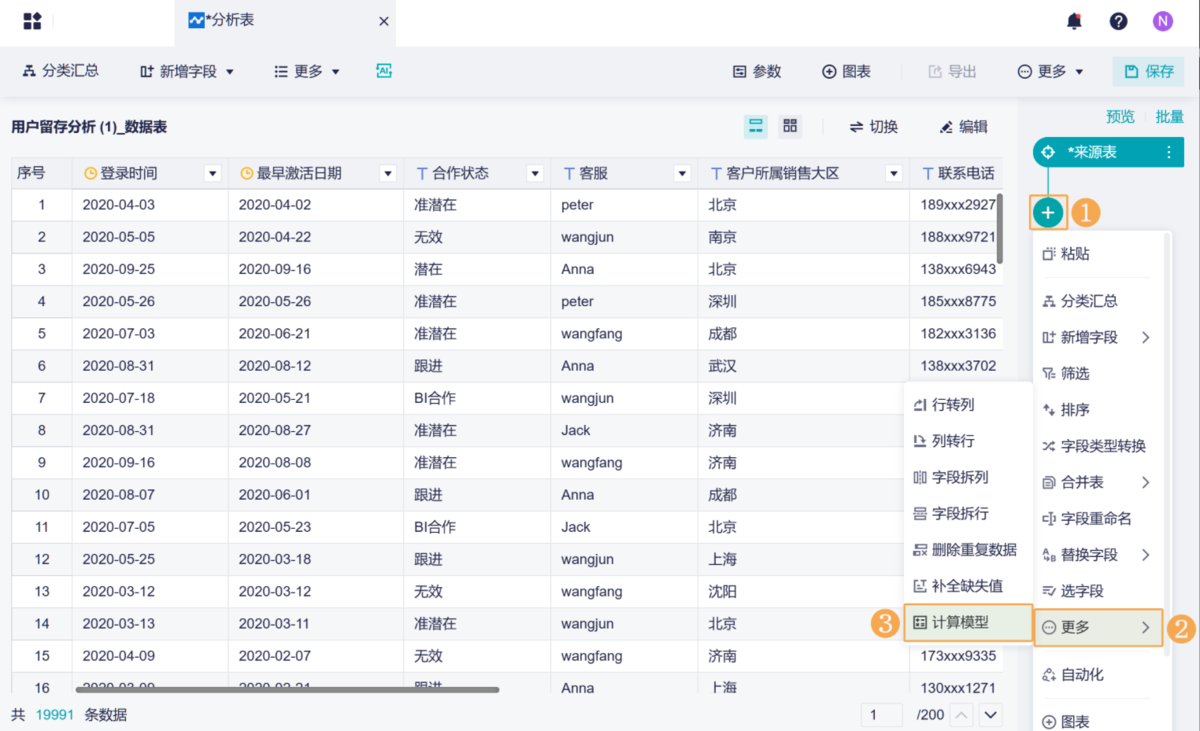

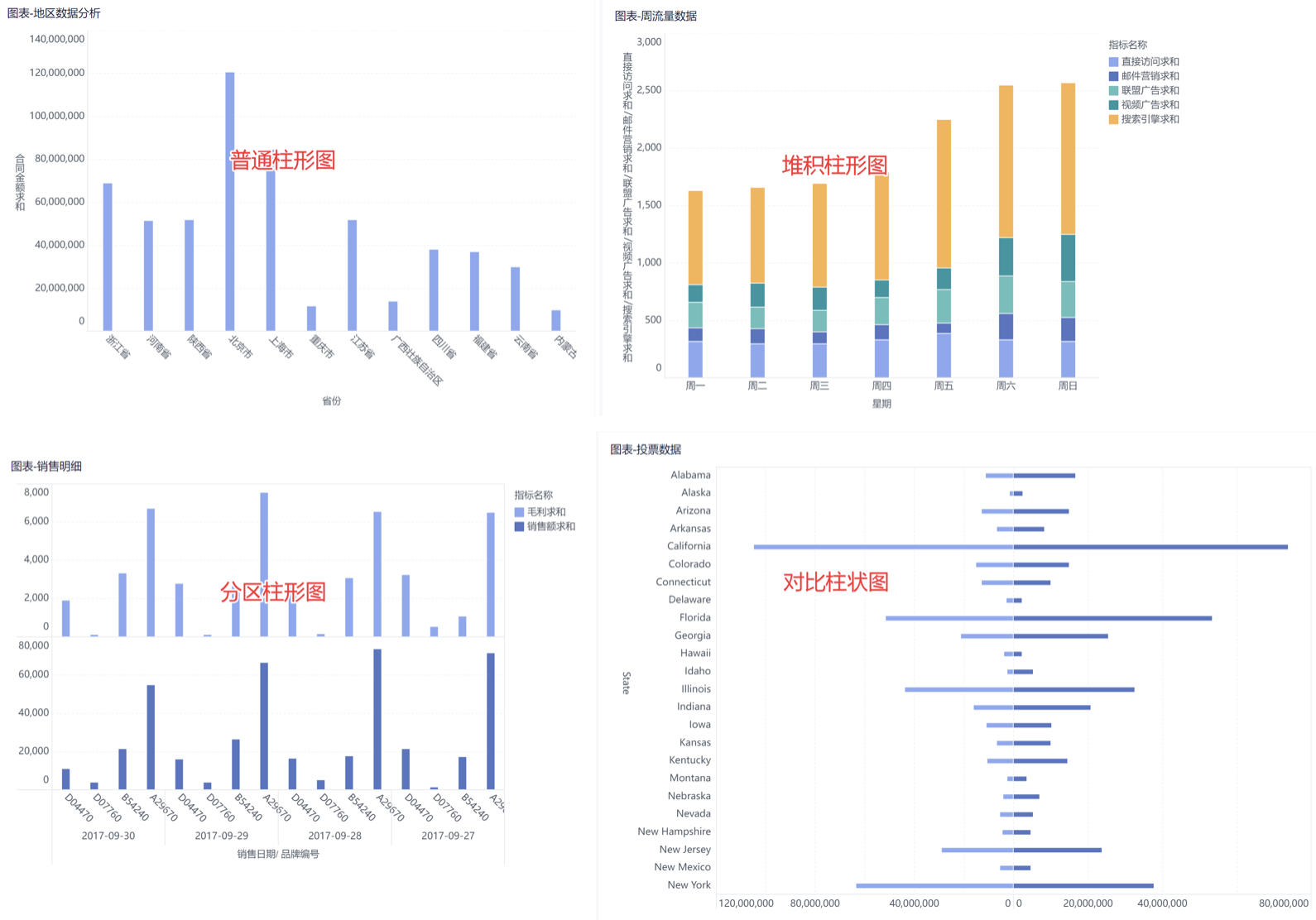

九数云BI采用自助式数据建模方式,无需编写复杂的代码,业务人员也可以轻松上手。通过拖拽式的操作,可以快速构建所需的数据模型,并进行灵活的调整和修改。

总结

数据建模分析是企业在数字化时代取得成功的关键。通过本文的介绍,相信您已经对数据建模分析有了更深入的了解。九数云BI作为高成长型企业首选的SAAS BI工具,将帮助您轻松应对数据挑战,释放数据价值,驱动业务增长。

热门产品推荐