3种数据采集的基本方式和实现思路 | 帆软九数云

在大数据时代,数据采集是数据化运营中至关重要的一环。例如电商平台上,会采集用户在网站上的行为进行跟踪和记录,获取例如浏览、点击、购买等数据;网站内容平台,会采集消费者在网站上的内容消费行为,获取例如阅读、分享、评论等数据。

这类数据非常关键,可以帮助电商平台优化用户体验、提升销售转化率。准确、及时地采集数据是进行数据分析和决策的基础。本文将介绍几种常见的数据采集方式,针对其优缺点及应用场景进行详细分析,帮助您选择最适合的方式进行数据采集。

一、数据采集方式

数据采集方式主要包括人工采集、报表采集和自动化抓取采集。每种方式有其优缺点及适用场景。

1. 人工采集

人工采集是指运营者通过基本的“复制粘贴”方式,从电商平台等数据源手动获取数据。常用于采集电商前台数据,如产品排名、介绍、评论等。

优点:

- 操作简单,无需技术门槛。

- 灵活方便,可根据具体需求手动调整。

缺点:

- 效率低下,耗时较长。

- 容易出错,数据准确性不高。

适用场景:

- 关键字优化、产品详情优化等重要领域。

2. 报表采集

报表采集是通过下载电商平台店铺后台的数据报表完成数据采集。适用于后台数据,如广告数据、订单数据、流量数据、店铺流量数据等。

优点:

- 操作相对简单,可选择具体时间段下载。

- 具有较高的准确性,避免手动操作的错误。

缺点:

- 等待时间较长,通常需 5分钟生成报表后下载。

- 无法实时获取数据,只能获取历史数据。

适用场景:

- 中小卖家的日常运营分析,广告效果评估等。

3. 自动化抓取采集

自动化抓取采集是通过爬虫程序或 API 接口,自动抓取电商平台数据。这种方法适用于量级大、重复性高的数据采集工作,如竞争对手数据监控、数据化选品等。

优点:

- 采集效率高,可在数分钟内完成大量数据抓取。

- 可实现实时数据更新,获取最新数据。

缺点:

- 对技术有要求,可能需要编写爬虫程序或调用 API 。

- 遵守平台政策,避免违反数据抓取规则。

适用场景:

- 数据量大、需要高频次更新的数据采集工作。

- 竞争对手分析、产品监测等。

二、自动化数据采集的实现方式

1、自主研发采集程序

自有研发爬虫程序,需要技术团队支持。适合拥有较强 IT 能力的大型企业。

2、使用 API 接口

通过调用官方 API 接口,如亚马逊 API,获取数据。适合具有一定技术能力的中小企业。

3、第三方数据工具

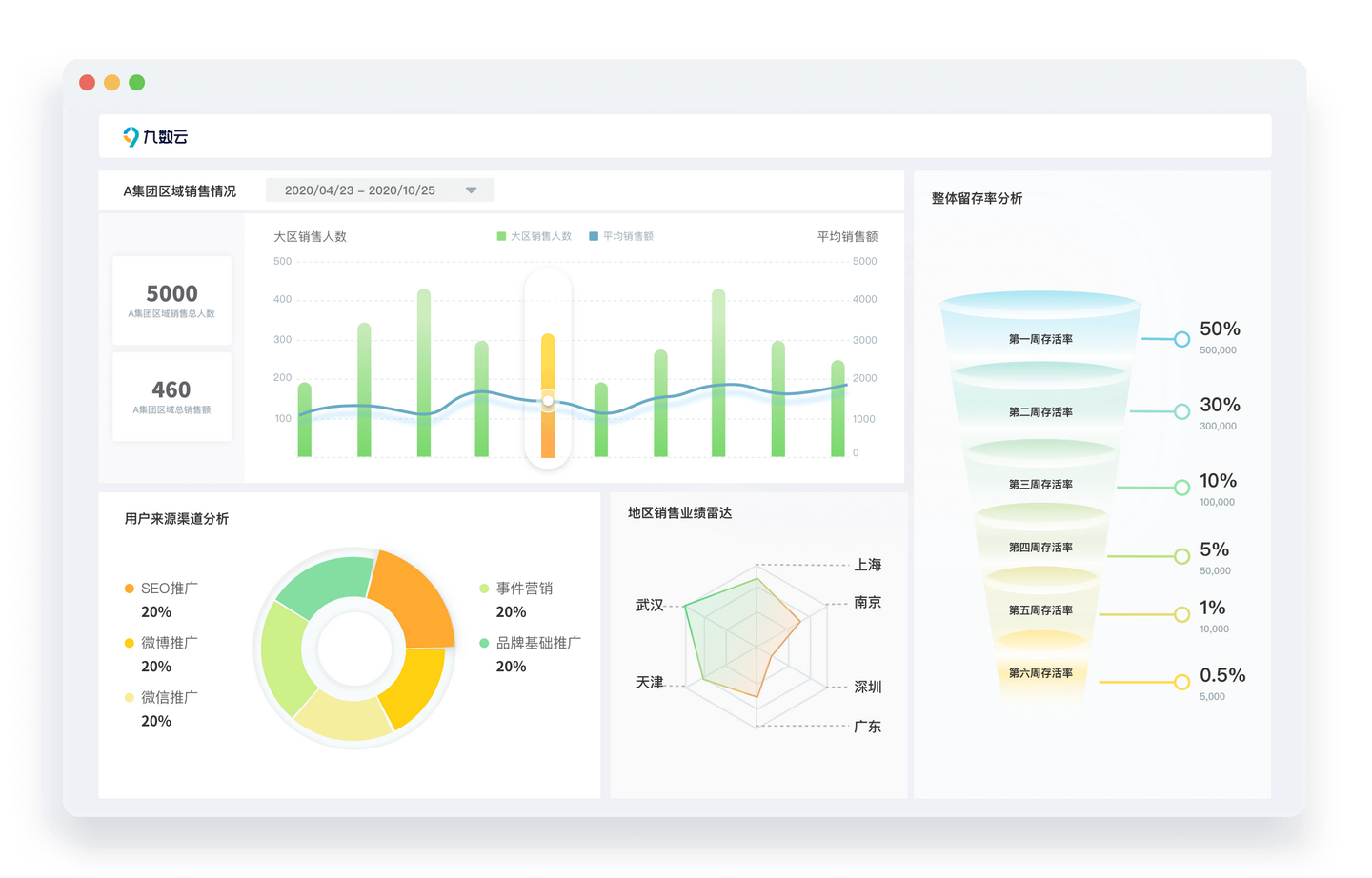

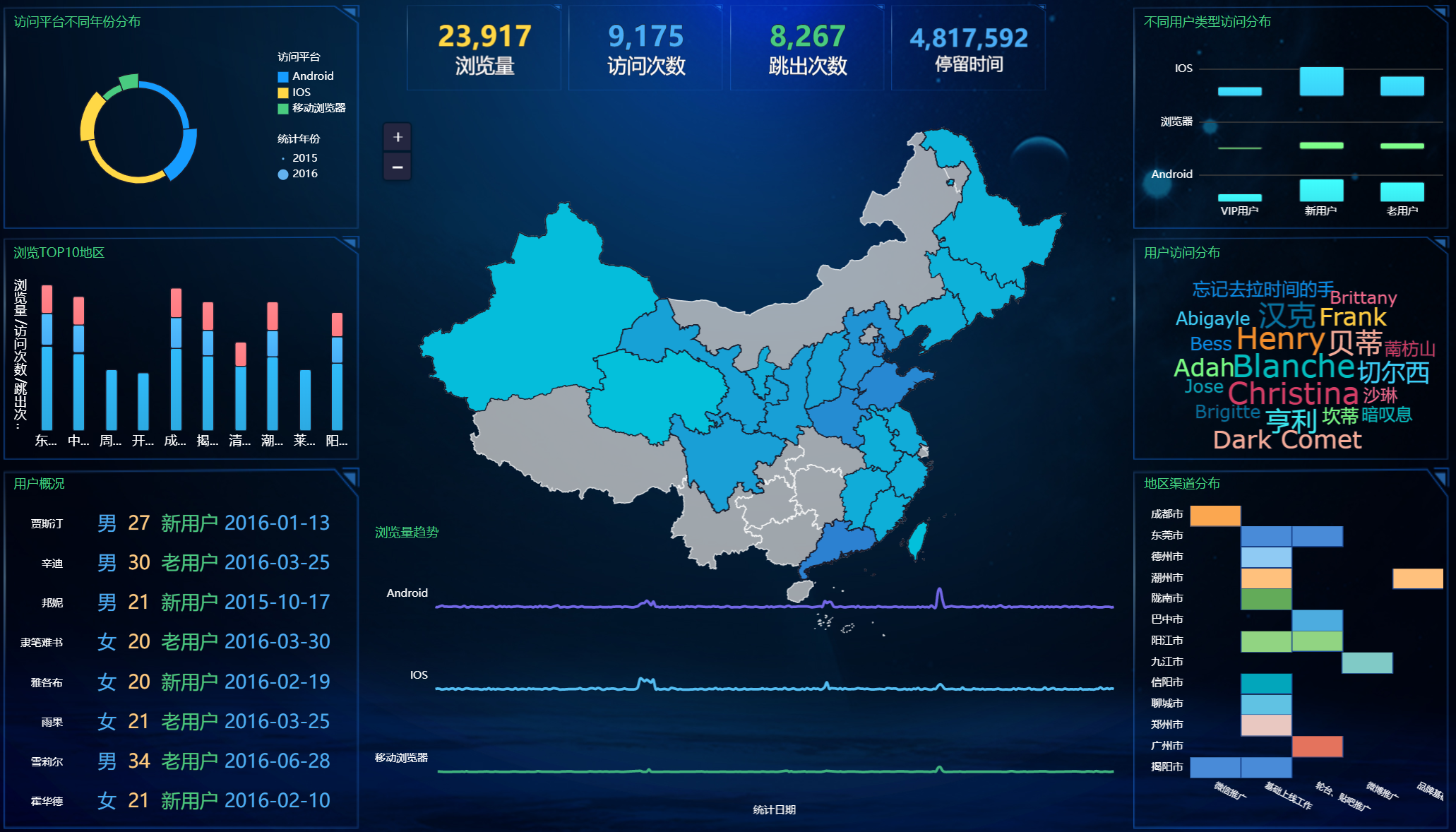

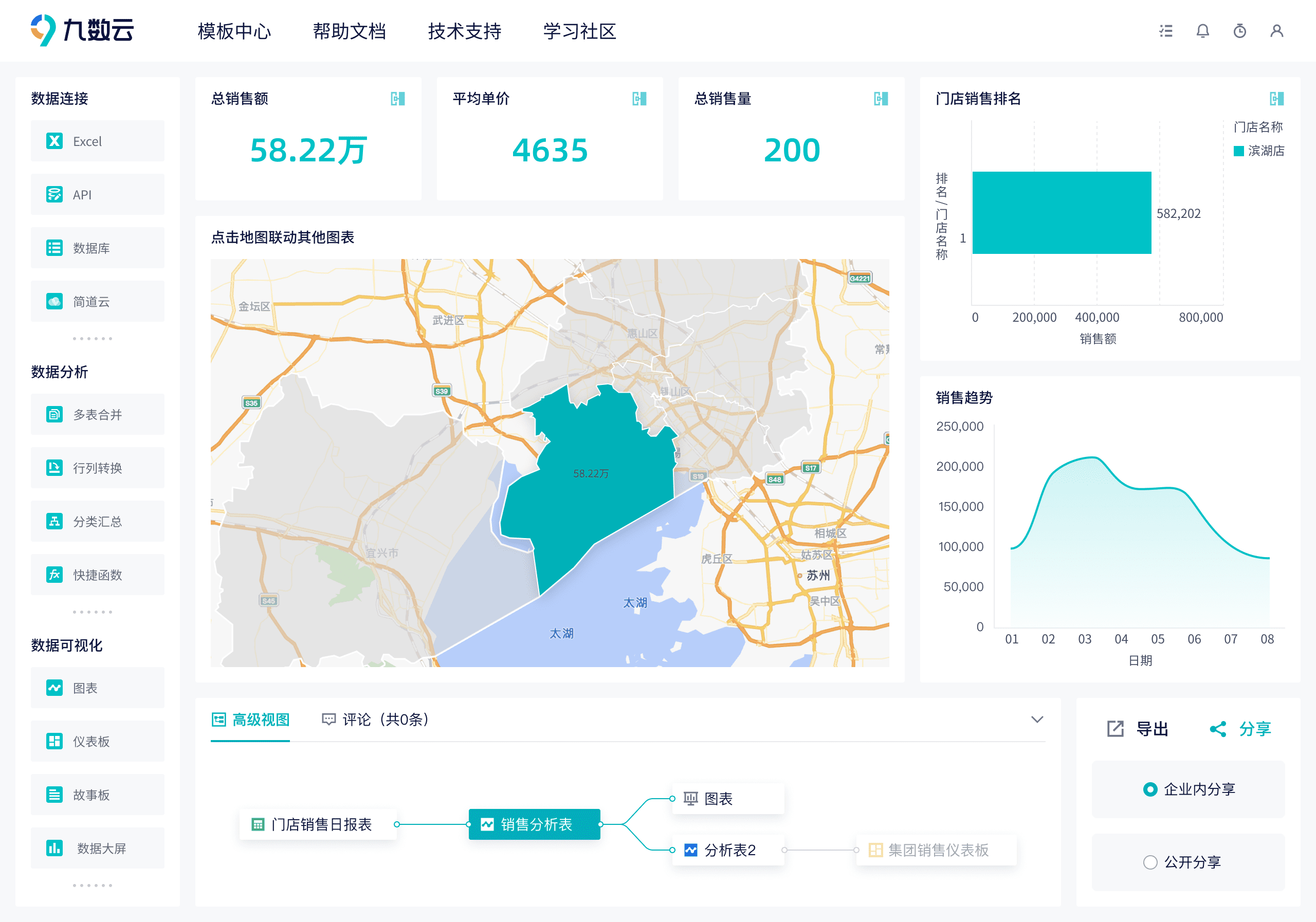

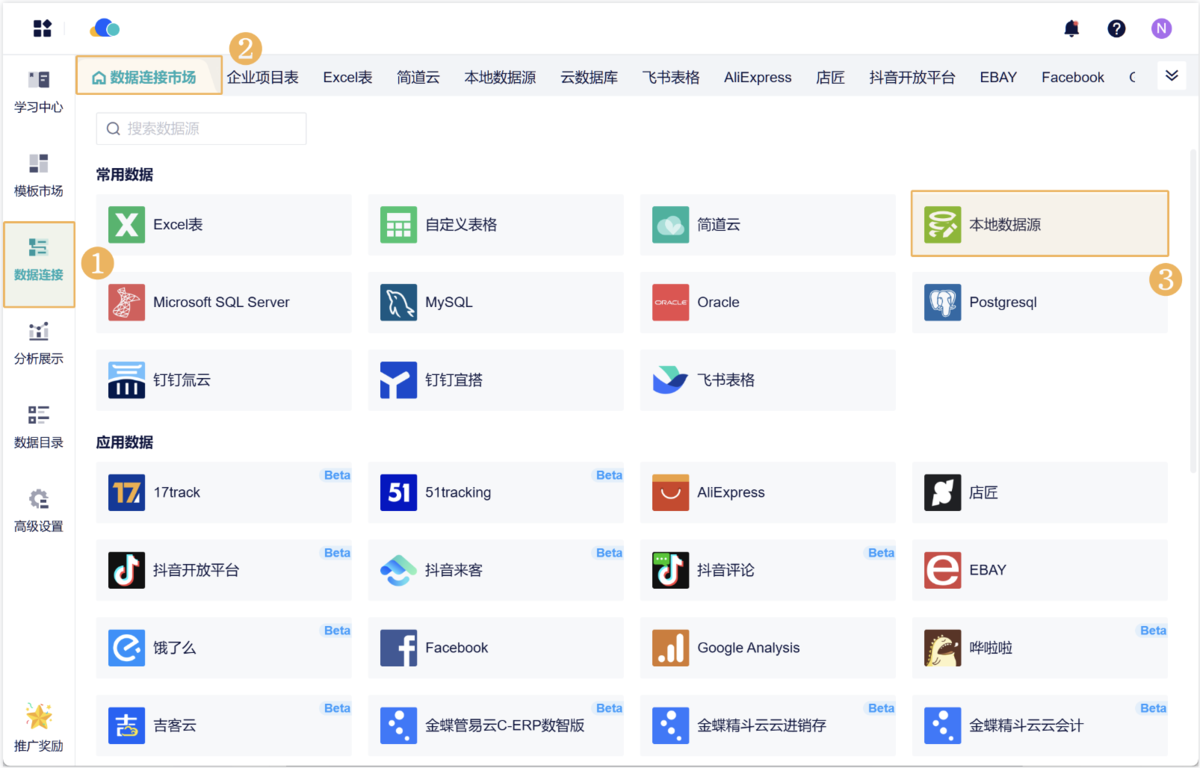

使用第三方工具自动抓取和分析数据,无需编写代码,使用简单。例如九数云BI支持多种数据源的连接功能,支持连接本地 Excel 文件、自定义表格、简道云数据、企业数据库和 API 接口数据。

用户可以通过九数云 BI 将企业内部及外部数据无缝集成,打破数据孤岛,实现数据的自动化流转,将不同平台的数据汇聚在一起进行统一管理和分析。

总结

选择合适的数据采集方式是实现数据化运营的关键。人工采集、报表采集和自动化抓取采集各有优缺点,企业需要根据具体需求和资源,灵活采用不同的数据采集方式。人工采集适用于小规模、灵活度高的场景;报表采集适用于中小企业的日常运营数据获取;自动化抓取采集适用于大规模、实时更新的数据需求。

希望本文的介绍能够帮助您深入了解数据采集的各种方式,选择最适合的方案,提升数据采集效率和数据质量,为业务决策提供可靠的数据支持。

热门产品推荐